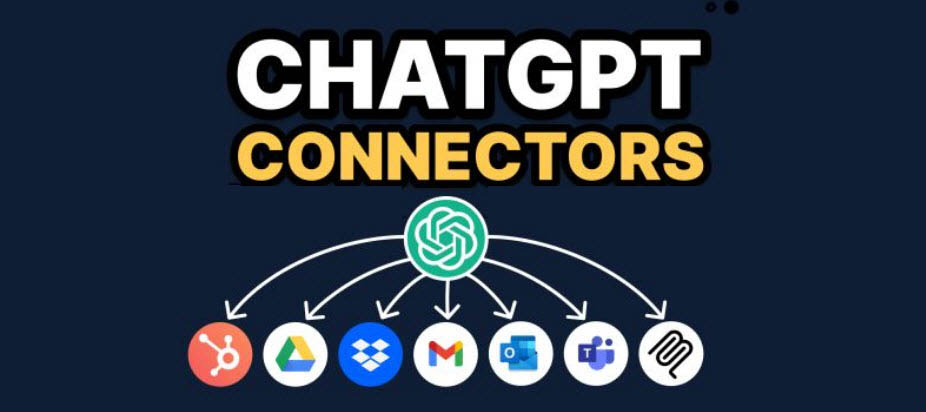

ChatGPT 5 – nieuwe connectoren openen deuren…ook naar jouw gevoelige data?

OpenAI heeft onlangs in ChatGPT 5 z.g. connectoren geïntroduceerd waarmee ChatGPT toegang krijgt tot gegevens in jouw Google Drive, Google mail of jouw Microsoft 365 omgeving. Hierdoor is ChatGPT in staat om informatie op te halen. Of het nu gaat om Microsoft 365 bestanden in de Cloud, interne bestanden of productiviteitstools, ChatGPT kan door systemen heen bewegen alsof het een menselijke gebruiker is. Dat is een krachtige ontwikkeling, maar het vergroot ook de urgentie van bescherming en toezicht.

OpenAI heeft onlangs in ChatGPT 5 z.g. connectoren geïntroduceerd waarmee ChatGPT toegang krijgt tot gegevens in jouw Google Drive, Google mail of jouw Microsoft 365 omgeving. Hierdoor is ChatGPT in staat om informatie op te halen. Of het nu gaat om Microsoft 365 bestanden in de Cloud, interne bestanden of productiviteitstools, ChatGPT kan door systemen heen bewegen alsof het een menselijke gebruiker is. Dat is een krachtige ontwikkeling, maar het vergroot ook de urgentie van bescherming en toezicht.

Risico’s van ongecontroleerde toegang

Het gebruik de connectoren in ChatGPT brengt aanzienlijke risico’s met zich mee voor organisaties. Wat gebeurt er wanneer AI-systemen interne systemen gaan benaderen zonder duidelijk toezicht of restricties?

Drie duidelijke knelpunten:

- Data restricties

Veel data binnen organisaties die Microsoft 365 gebruiken is nog niet voorzien van labels of metadata. Daardoor kan AI onbedoeld data gebruiken, zoals gevoelige HR‑bestanden, financiële concepten of persoonlijke notities. - Waar komt de data vandaan?

Wanneer AI informatie haalt uit meerdere bronnen, wordt het lastig om vast te stellen waar de data oorspronkelijk vandaan komt, wie het heeft gemaakt, of het gevalideerd is, en of het betrouwbaar is. Deze ondoorzichtigheid ondermijnt de mogelijkheid tot audit en verantwoording. - Data governance

Toegangscontroles alleen zijn niet voldoende. Organisaties moeten fijnmazige governance implementeren die niet alleen regelt wie toegang heeft, maar ook hoe data gebruikt wordt — zowel door mensen als AI-agents.

Bezint eer gij begint

Naarmate gebruik van AI‑connectoren binnen organisaties toeneemt, moeten ICT teams deze zien als een nieuwe integratievorm één die strenger toezicht en controle vereist dan de meeste huidige systemen. Actie hierop betekent meer dan alleen permissies aanpassen of interne richtlijnen verstrekken; het vraagt o.a. ook om heldere beleidslijnen op te stellen.

Deze moeten bepalen:

• Welke type data blootgesteld mag worden

• Monitoring om gebruikspatronen te volgen

• Verantwoordelijkheid voor toegang en gebruik vaststellen

Organisaties zouden ook hun data‑architectuur moeten herzien. Het is niet meer genoeg om alleen te bepalen wie toegang heeft; je moet ook precies kunnen specificeren hoe elk datapunt gebruikt mag worden, onder welke voorwaarden en door welke agenten (menselijk of AI).

Bronvermelding:

https://www.indykite.com/blogs/openai-connectors-are-live---and-your-data-might-be-too?utm_source=chatgpt